Jeśli pracujesz z biblioteką Keras i chcesz użyć tensorboard do wydrukowania wykresów dokładności i innych zmiennych, poniżej znajdują się kroki, które należy wykonać.

Krok 1: Zainicjuj bibliotekę wywołań zwrotnych keras, aby zaimportować tensorboard za pomocą poniższego polecenia

from keras.callbacks import TensorBoard

krok 2: Dołącz poniższą komendę do swojego programu tuż przed komendą "model.fit ()".

tensor_board = TensorBoard(log_dir='./Graph', histogram_freq=0, write_graph=True, write_images=True)

Uwaga: użyj „./graph”. Wygeneruje folder wykresów w Twoim bieżącym katalogu roboczym, unikaj używania "/ graph".

krok 3: Uwzględnij wywołanie zwrotne Tensorboard w „model.fit ()”. Przykład znajduje się poniżej.

model.fit(X_train,y_train, batch_size=batch_size, epochs=nb_epoch, verbose=1, validation_split=0.2,callbacks=[tensor_board])

krok 4: Uruchom kod i sprawdź, czy folder z wykresami znajduje się w katalogu roboczym. jeśli powyższe kody działają poprawnie, w katalogu roboczym będziesz mieć folder „Graph”.

krok 5: Otwórz Terminal w katalogu roboczym i wpisz poniższe polecenie.

tensorboard --logdir ./Graph

Krok 6: Teraz otwórz przeglądarkę internetową i wprowadź poniższy adres.

http://localhost:6006

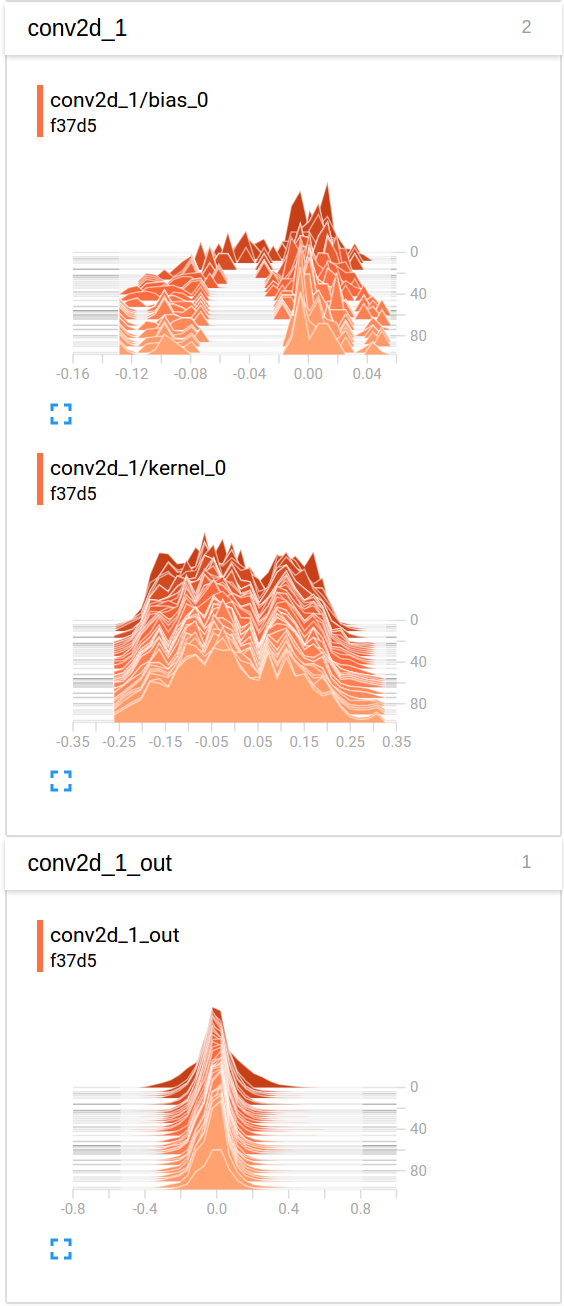

Po wejściu otworzy się strona Tensorbaord, na której możesz zobaczyć wykresy różnych zmiennych.

histogram_freqdo1. "histogram_freq: częstotliwość (w epokach), przy której należy obliczyć histogramy aktywacji dla warstw modelu. Jeśli jest ustawiona na 0, histogramy nie będą obliczane."