Poprzednie wyzwania gry w golfa w sieci neuronowej ( to i tamto ) zainspirowały mnie do postawienia nowego wyzwania:

Wyzwanie

Znajdź najmniejszą sieć neuronową ze sprzężeniem zwrotnym, taką, że biorąc pod uwagę dowolny 4-wymiarowy wektor wejściowy z wpisami liczb całkowitych w , wyjścia sieciowe pomocą błąd współrzędnych ściśle mniejszy niż .

Dopuszczalność

W przypadku tego wyzwania sieć neuronowa typu feed-forward jest definiowana jako kompozycja warstw . Warstwa jest funkcją , która jest określona przez matrycę ∈ R m x n z ciężarkami , wektor b ∈ R m z odchyleń , i aktywacja funkcji F : R → R , który jest stosowany coordinate- mądry:

Ponieważ funkcje aktywacyjne można dostosować do dowolnego zadania, musimy ograniczyć klasę funkcji aktywacyjnych, aby wyzwanie było interesujące. Dozwolone są następujące funkcje aktywacji:

Tożsamość.

ReLU.

Softplus.

Styczna hiperboliczna.

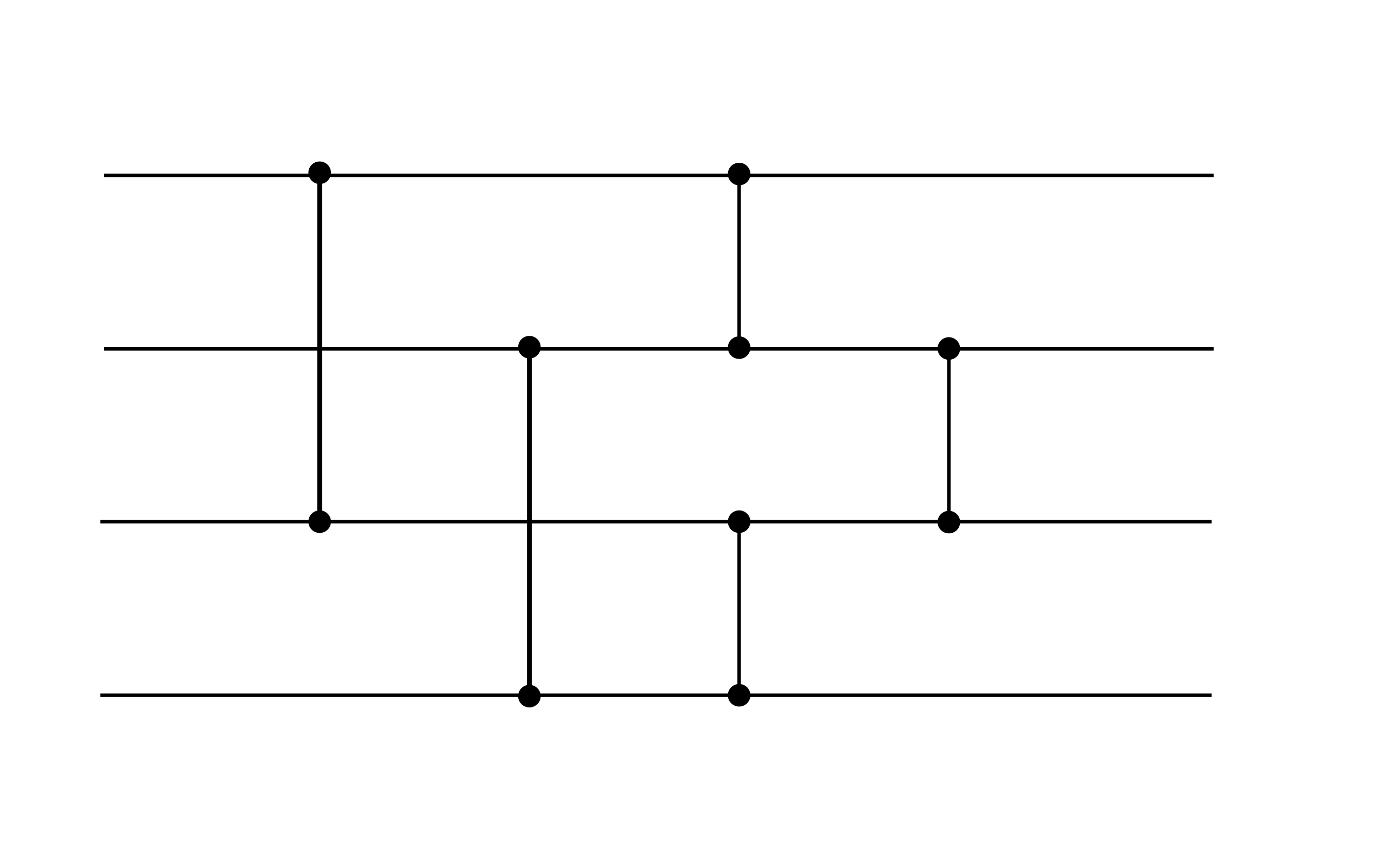

Sigmoid.

Ogólnie rzecz biorąc, dopuszczalne sieć neuronowa ma postać z jakiegoś , gdzie każda warstwa jest określony przez wag , odchyleń i funkcji aktywacji z powyższej listy. Na przykład dopuszczalna jest następująca sieć neuronowa (chociaż nie spełnia celu wydajności tego wyzwania, może być przydatnym gadżetem):

Ten przykład pokazuje dwie warstwy. Obie warstwy mają zerowe obciążenie. Pierwsza warstwa wykorzystuje aktywację ReLU, a druga aktywację tożsamości.

Punktacja

Twój wynik to łączna liczba niezerowych wag i odchyleń.

(Np. Powyższy przykład ma wynik 16, ponieważ wektory odchylenia są równe zero.)